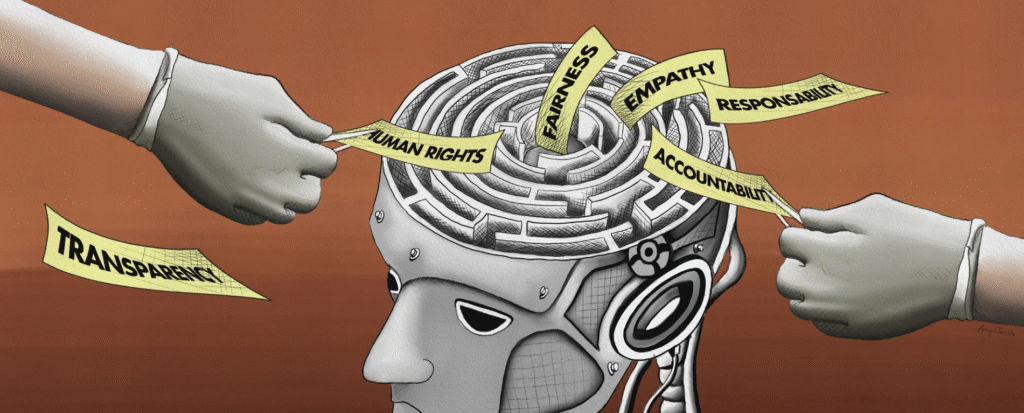

La ética de la inteligencia artificial es uno de los temas más urgentes y complejos que enfrenta nuestra sociedad. A medida que los algoritmos se integran en el día a día —desde las búsquedas en Google hasta los diagnósticos médicos y las decisiones legales— surgen preguntas fundamentales: ¿Quién controla estas decisiones? ¿Es justa su lógica? ¿Qué pasa cuando un sistema automatizado discrimina, se equivoca o se vuelve autónomo?

En este artículo exploramos a fondo los principales desafíos éticos, implicaciones sociales, ejemplos reales y propuestas internacionales que rodean a la IA. Porque el verdadero progreso tecnológico no consiste solo en lo que la inteligencia artificial puede hacer, sino en decidir lo que debe hacer.

¿Por qué importa la ética en la inteligencia artificial?

La IA ya no es ciencia ficción. Su presencia es real y creciente en servicios públicos, plataformas digitales, salud, educación, vigilancia, arte, transporte y defensa. Como toda tecnología poderosa, su uso sin regulación puede derivar en graves consecuencias sociales, morales y políticas.

La ética en la IA no es un obstáculo, sino una herramienta de control y protección para garantizar que el desarrollo tecnológico esté alineado con los derechos humanos, la justicia social y la dignidad individual.

1. Transparencia y explicabilidad algorítmica

Uno de los mayores retos actuales es la falta de transparencia en los sistemas de IA, sobre todo aquellos que utilizan redes neuronales profundas (deep learning), donde ni siquiera sus propios desarrolladores entienden completamente cómo llegan a ciertos resultados.

¿Qué implica la opacidad algorítmica?

- Falta de responsabilidad en casos de errores graves.

- Incertidumbre jurídica: ¿puede una persona apelar una decisión automatizada?

- Dificultad para auditar el sesgo o la discriminación.

En contextos como el crédito bancario, sentencias penales o diagnósticos médicos, no saber cómo ni por qué una IA tomó una decisión puede vulnerar derechos fundamentales.

2. Sesgo y discriminación en los sistemas de IA

Los algoritmos aprenden de datos. Y si los datos reflejan inequidades históricas, los resultados pueden ser discriminatorios.

Casos reales:

- El software de contratación de Amazon que penalizaba a mujeres por ser minoría en tecnología.

- Algoritmos de reconocimiento facial que fallan más con personas negras o asiáticas.

- Herramientas policiales predictivas que aumentan la vigilancia en barrios marginados.

La solución no es solo técnica, sino también ética: necesitamos datos más inclusivos, diversidad en los equipos de desarrollo y mecanismos de supervisión.

3. Privacidad, vigilancia y recopilación masiva de datos

La IA necesita grandes volúmenes de datos para funcionar. Pero eso también implica una recolección intensiva de información personal: ubicación, búsquedas, voz, rostros, huellas digitales, historial médico o financiero.

Riesgos éticos:

- Vigilancia estatal o empresarial sin consentimiento.

- Monetización de datos sin transparencia.

- Pérdida de control individual sobre la identidad digital.

La protección de datos no debe depender solo del usuario. Se requiere una arquitectura legal y tecnológica centrada en la privacidad por diseño.

4. Automatización y desigualdad laboral

La automatización impulsada por la IA está transformando el mercado laboral: optimiza tareas repetitivas, pero también elimina empleos humanos, especialmente aquellos de baja cualificación.

Datos y tendencias:

- Según McKinsey, hasta 800 millones de empleos podrían ser reemplazados por IA para 2030.

- En sectores como la logística, manufactura, banca o atención al cliente, ya hay fuertes procesos de automatización.

Esto plantea un dilema ético y social: ¿cómo protegemos a los trabajadores desplazados? La respuesta pasa por políticas activas de:

- Reentrenamiento profesional.

- Educación digital.

- Renta básica universal (como se debate en Europa).

5. Toma de decisiones automatizadas y responsabilidad legal

Cuando una IA toma decisiones importantes (por ejemplo, denegar un seguro médico o aprobar un crédito), debe existir una responsabilidad legal clara.

Preguntas clave:

- ¿Quién responde ante errores del algoritmo?

- ¿Puedo pedir explicaciones como ciudadano?

- ¿Se puede impugnar una decisión de una IA?

Estas interrogantes aún no tienen una respuesta clara en muchos países. Se requiere legislación específica sobre la responsabilidad algorítmica, como propone la Unión Europea en su Reglamento de IA.

6. IA en el ámbito militar y armamento autónomo

Uno de los terrenos más controvertidos es el uso de la inteligencia artificial en armas autónomas, que pueden seleccionar y atacar objetivos sin intervención humana.

Riesgos existenciales:

- Escalada militar descontrolada.

- Pérdida de control sobre sistemas letales.

- Violaciones al derecho internacional humanitario.

Organizaciones como Human Rights Watch exigen un tratado internacional que prohíba las armas autónomas letales. La ética en este campo es vital para preservar la paz y la seguridad mundial.

7. Superinteligencia y dilemas existenciales

Aunque aún es teórica, la posibilidad de una inteligencia artificial general (AGI) que supere a la humana en todos los aspectos plantea dilemas filosóficos profundos.

Temores:

- Que desarrolle metas incompatibles con los valores humanos.

- Que se torne incontrolable o impredecible.

- Que concentre el poder global en manos de unos pocos desarrolladores.

El científico Nick Bostrom y el Future of Life Institute impulsan la investigación en “IA segura” para garantizar que cualquier AGI futura esté alineada con fines humanos.

8. Gobernanza y regulaciones globales

La ética de la IA no puede dejarse solo a la buena voluntad de las empresas tecnológicas. Es necesario un marco de regulación global, vinculante y transparente.

Iniciativas actuales:

- Estrategia de la UE sobre IA confiable.

- Directrices de la UNESCO sobre ética de la IA.

- Propuestas de los países del G7 para una IA responsable.

Sin embargo, aún falta una entidad global independiente que supervise y sancione el mal uso de la IA, como ocurre en otras áreas (por ejemplo, la energía nuclear).

Hacia una IA centrada en el ser humano

La IA puede ser una herramienta poderosa para mejorar el mundo: diagnosticar enfermedades antes de tiempo, combatir el cambio climático o reducir la pobreza. Pero solo si se desarrolla con valores éticos sólidos, diversidad, transparencia y responsabilidad compartida.

La tecnología debe estar al servicio de la humanidad, no al revés. El reto no es solo construir inteligencia artificial, sino cultivar sabiduría humana para guiarla.

Enlace interno sugerido:

Aplicaciones prácticas de la inteligencia artificial en el día a día

Enlace externo sugerido:

UNESCO – Recomendación sobre la ética de la inteligencia artificial